Coraz więcej marketerów wdraża najnowocześniejsze rozwiązania, opierające się o technologię AI, które nie tylko optymalizują dane procesy marketingowe (np. content marketing czy relationship marketing), lecz przede wszystkim rozpościerają przed marketerami szereg nowych, nieznanych dotąd możliwości rozwoju firmy. Jednakowoż należy także przyjrzeć się drugiej stronie tego medalu, jaką jest kwestia regulacji prawnych korzystania z AI oraz – co za tym idzie – potencjalna problematyczność w wykorzystaniu tej technologii w niektórych gałęziach marketingu.

Obecny udział AI w branży marketingowej

Oceny zgodności – conformity assessments (CA)

Systemy sztucznej inteligencji a prawa autorskie

Regulacje dotyczące AI vs marketerzy

Obecny udział AI w branży marketingowej

W połowie stycznia 2024 portal Influencer Marketing Hub opublikował raport podsumowujący rok 2023 w kontekście wykorzystywania AI w kluczowych dla nas gałęziach gospodarki. Na potrzeby raportu przebadano około 2700 osób, największy zaś ich odsetek, bo ponad 25%, stanowili marketerzy oraz ludzie z branży reklamowej. Wyniki przedstawiały się następująco:

- prawie 62% marketerów deklarowało, że korzysta z rozwiązań oferowanych przez AI w swojej działalności;

- niemalże 45% respondentów korzystało z AI przy tworzeniu contentu;

- 82% marketerów było zdania, że treści tworzone przez AI są tak samo dobre (lub lepsze) od tych tworzonych przez ludzi;

- 63% marketerów korzystało z narzędzi AI przy e-mail marketingu;

- prawie 20% respondentów przeznaczało ponad 40% swojego budżetu marketingowego na kampanie oparte o AI;

- ponad 60% planowało wykorzystać AI przy tworzeniu kampanii influencerskich;

- głównymi powodami, dla których część respondentów nie korzystała z możliwości, jakie oferuje sztuczna inteligencja, były: wysoki koszt implementacji AI oraz brak zrozumienia zasad, na których się ona opiera;

Podczas gdy odsetek firm korzystających z co najmniej jednej zaawansowanej technologii cyfrowej jest obecnie podobny po obu stronach Atlantyku, firmy amerykańskie wydają się wyprzedzać pod względem wykorzystania analityki dużych zbiorów danych i sztucznej inteligencji, a dane EIBIS [EIB Investment Survey] wskazują na różnicę 6 punktów procentowych między Stanami Zjednoczonymi a Europą, jak możemy przeczytać w „Investment Report 2023/2024. Transforming for Competitiveness”.

Okiem Eksperta

Piotr Bombol

Co-Founder w adaily.co

W jaki sposób AI może wspierać tworzenie spersonalizowanych kampanii reklamowych?

Półtora roku po premierze ChatGPT nikogo nie trzeba przekonywać do możliwości, jakie daje AI. Praktycznie każdego tygodnia widzimy nowy przełom w technologii, ostatnio szczególnie w zakresie generowania filmów z tekstowych opisów (“promptów”). Generatywne AI daje możliwość tworzenia contentu w praktycznie nieograniczonej liczbie i w dowolnej kombinacji. Powstają dedykowane platformy, które potrafią łączyć dane mediowe z silnikami tworzenia treści, a następnie zestawiać to z efektywnością kreacji. Dzięki temu platforma jak Pencil może operować na wnioskach z kampanii o łącznej wartości 1 mld dolarów.

Rewolucja AI pozwala każdemu testować własne pomysły i tworzyć dedykowane rozwiązania. Przykładowo agencja Tombras zrealizowała hiper-spersonalizowaną kampanię outdoor w Nowym Jorku dla klienta PODS, lidera w kategorii przeprowadzek i magazynowania.

Ich pomysłem było użycie Gemini AI od Google do generowania kontekstowych reklam wyświetlanych na ekranach LED zainstalowanych na ciężarówkach PODS, wspieranych przez Google Cloud Vertex AI. Do stworzenia 6000 unikalnych nagłówków reklamowych wykorzystano dane takie jak transkrypcje rozmów, dokumenty marki, podcasty, filmy oraz ponad 10 000 recenzji Google. Takie podejście przekształciło ciężarówki w inteligentne, dynamiczne billboardy, pokazując potencjał reklamy napędzanej przez sztuczną inteligencję.

Choć narzędzia AI najczęściej wykorzystywane są przy produkcji content marketingu i szeroko rozumianych treści, tak sztuczna inteligencja powoli zagnieżdża się także w marketingu optymalizacyjnym, analitycznym czy w obsłudze klienta.

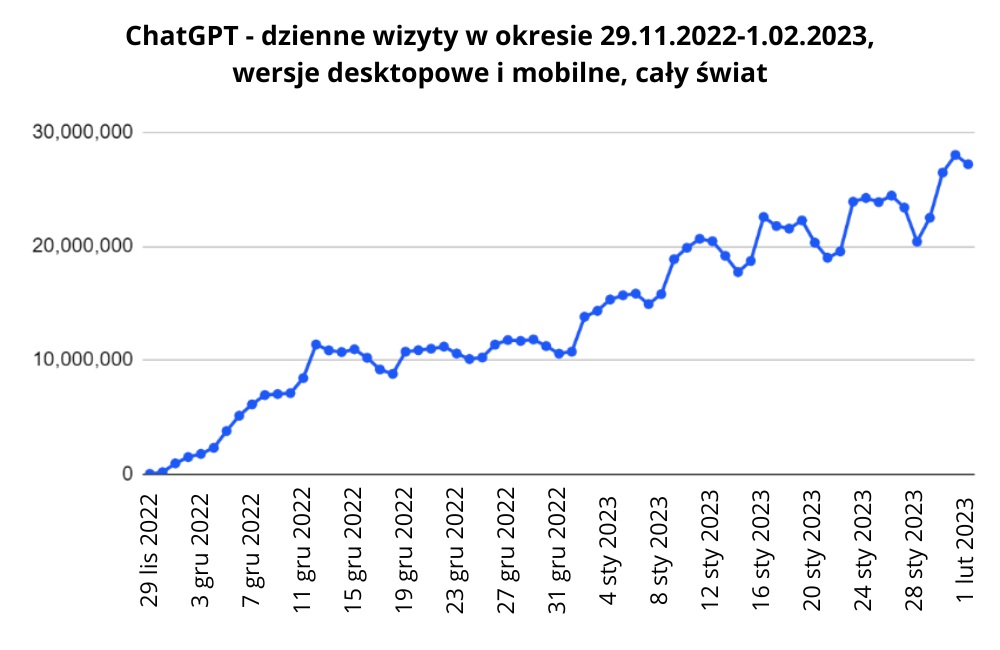

Warto też zaznaczyć, że stale zyskujący na popularności ChatGPT stał się najszybciej rozwijającą się aplikacją konsumencką w historii. W styczniu zeszłego roku, a więc dwa miesiące po publikacji, odnotował on liczbę 100 milionów aktywnych użytkowników. Dla porównania wykręcenie tak oszałamiających liczb zajęło TikTokowi dziewięć miesięcy, Instagramowi zaś – dwa i pół roku.

Już w 2018 roku globalna firma marketingowa z zakresu zarządzania – McKinsey & Company – przeprowadziła symulację dotyczącą wpływu, jaki na światową ekonomię będzie miał rozwój AI. Marketerzy doszli wówczas do konkluzji, że do 2030 roku aż 70% ogółu firm, spółek itd. zaimplementuje u siebie co najmniej jedno z rozwiązań, jakie umożliwiają narzędzia sztucznej inteligencji. Z dzisiejszej perspektywy wydaje się to bardziej prawdopodobne niż kiedykolwiek przedtem.

Okiem Eksperta

Grzegorz Miłkowski

CEO CONTENTHOUSE i redaktor naczelny SOCIALPRESS

Czy AI może pomóc w zwalczaniu dezinformacji w marketingu i mediach społecznościowych?

W 2023 roku około 2 z 3 marketerów używało AI, a blisko połowa wykorzystywała ją do tworzenia treści. W tym kontekście niezwykle istotnym aspektem jest zdolność tzw. sztucznej inteligencji do zwalczania dezinformacji.

Jednak sama w sobie technologia nie wystarczy. Konieczne są zmiany w regulacjach prawnych, jak np. AI Act, który klasyfikuje systemy sztucznej inteligencji według poziomu ryzyka i nakłada surowe wymogi dotyczące jakości danych i przejrzystości algorytmów.

AI ma ogromny potencjał w zwalczaniu dezinformacji, m.in. w marketingu i mediach społecznościowych. Zaawansowane algorytmy do analizy i weryfikacji treści, w połączeniu z odpowiednimi regulacjami prawnymi i nadzorem, mogą szybciej i skuteczniej poprawić jakość i zaufanie konsumentów do treści. Jednak kluczowe jest, aby technologia ta była używana etycznie i odpowiedzialnie, z poszanowaniem zasad transparentności i odpowiedzialności.

W tym przypadku kluczowy wydaje się ludzki nadzór nad AI i jej działaniem, również w obszarze walczenia z dezinformacją. Sztuczna inteligencja może wspierać procesy monitorowania i zwalczania dezinformacji, ale ostateczna decyzja o klasyfikacji treści powinna należeć do ludzi, lepiej oceniających kontekst i niuanse, których algorytmy, przy obecnym poziomie rozwoju tej technologii, mogą nie „zauważyć”. W przyszłości, wraz z rozwojem AI, niewskazane też będzie oddawanie jej całkowitej kontroli nad taką walką, mimo silnej pokusy optymalizacji takich procesów. Człowiek zawsze pozostanie tą „wolniejszą maszyną”, jednakże nieustannie mądrzej analizującą treści niż nawet najbardziej zaawansowany algorytm.

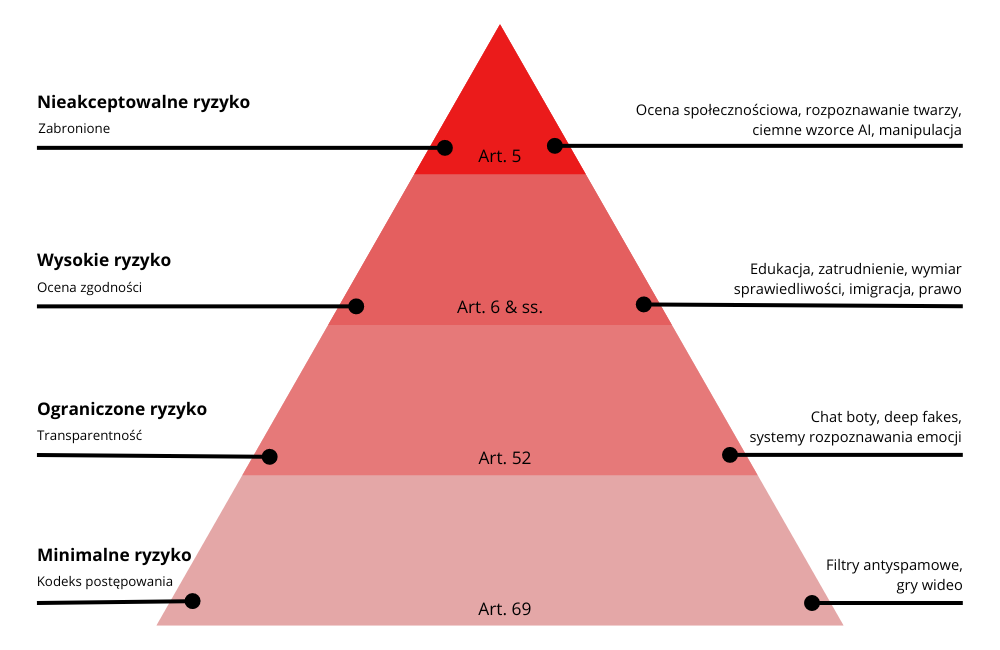

Kwestia AI Act

W kwietniu 2021 r. Komisja Europejska zaproponowała pierwsze unijne ramy legislacyjne, dotyczące sztucznej inteligencji. Projekt poddawał systemy AI dogłębnej klasyfikacji, sortując je zgodnie z poziomem ryzyka, jaki ze sobą niosą użytkownikom. Różne stopnie ryzyka będą niosły ze sobą mniej lub więcej obowiązków i regulacji, którym dany system będzie musiał się podporządkować.

Sam projekt AI Act stał się faktem względnie niedawno, bo 13 marca 2024 roku – zdecydowaną większością głosów (523 za, 46 przeciw, 49 wstrzymujących się) regulacja została przyjęta przez europarlament.

Jak możemy przeczytać na oficjalnej stronie Parlamentu Europejskiego, pracom nad AI Act przyświecała chęć dopilnowania, aby systemy sztucznej inteligencji stosowane we Wspólnocie były bezpieczne, przejrzyste, identyfikowalne, niedyskryminujące i przyjazne dla środowiska. Władze unijne na każdym kroku podkreślają, że AI powinna służyć człowiekowi i być zarządzana przez niego, aby zapobiegać “wszelkim skutkom niepożądanym”.

Okiem Eksperta

Maja Wiśniewska-Hardek

Head of Marketing w SMSAPI

Czy technologia AI ma szansę się sprawdzić w kampaniach znanych marek robionych na dużą skalę, czy jest to działanie wyłącznie dla małych i średnich firm?

Wykorzystanie AI w sektorze MŚP kojarzy się dziś z prostymi promptami w ChatGPT. Faktem jest, że modele generatywne, tak popularne przy tworzeniu treści czy obrazów, są po prostu najbardziej dostępnymi z gotowych narzędzi. Firmy najzwyczajniej przyśpieszają w ten sposób codzienną pracę, optymalizują procesy, ale AI może odgrywać też zdecydowanie trudniejszej role. Wielkość biznesu, sektor czy branża nie mają znaczenia – liczy się pomysł i cel wykorzystania technologii.

Ciekawym przykładem jest Nike, który na 50. rocznicę powstania marki opracował kampanię “Never Done Evolving” z Sereną Williams. Wykorzystując sztuczną inteligencję przeanalizowali mecz tenisistki z 1999 roku, kiedy zdobyła swój pierwszy tytuł Wielkiego Szlema oraz Sereną, która wygrała Australian Open w 2017 roku. Powstały w ten sposób zestaw danych posłużył do wygenerowania modelu obejmującego każdy aspekt stylu gry, od czasu reakcji, przez ulubione zagrywki, po drobne wariacje w podejmowanych decyzjach “obu zawodniczek”. Pojedynek między Serenami z 1999 i 2017 był transmitowany na żywo na YouTube, docierając do ponad 1,69 miliona subskrybentów Nike.

Nowe przepisy regulują powinności dostawców i użytkowników w zależności od poziomu ryzyka, jaki nieść ze sobą będzie dany system lub narzędzie AI:

1 | Systemy AI niedopuszczalnego ryzyka:

- poznawczo-behawioralna manipulacja ludźmi lub określonymi wrażliwymi grupami (na przykład zabawki aktywowane głosem, które zachęcają dzieci do niebezpiecznych zachowań);

- identyfikacja biometryczna i kategoryzacja osób fizycznych;

- scoring obywateli, czyli klasyfikacja ludzi na podstawie ich zachowań, statusu społeczno-ekonomicznego czy cech osobistych;

- systemy identyfikacji biometrycznej działające w czasie rzeczywistym i zdalnie, takie jak rozpoznawanie twarzy;

Warto pamiętać, że pewne wyjątki mogą być dopuszczalne do celów egzekwowania prawa. Systemy zdalnej identyfikacji biometrycznej działające w czasie rzeczywistym będą dozwolone w ograniczonej liczbie poważnych przypadków, natomiast systemy identyfikujące ze znacznym opóźnieniem będą mogły być używane do ścigania poważnych przestępstw, jednakże wyłącznie za zgodą sądu.

2 | Systemy AI wysokiego ryzyka:

a) Systemy sztucznej inteligencji stosowane w produktach objętych unijnymi przepisami dotyczącymi bezpieczeństwa produktów (np. zabawki, lotnictwo, samochody, urządzenia medyczne i windy);

b) Systemy sztucznej inteligencji należące do ośmiu konkretnych obszarów, które będą musiały zostać zarejestrowane w unijnej bazie danych;

- zarządzanie i eksploatacja infrastruktury krytycznej;

- edukacja i szkolenie zawodowe;

- zatrudnienie, zarządzanie pracownikami i dostęp do samozatrudnienia;

- dostęp do i korzystanie z podstawowych usług prywatnych oraz usług i korzyści publicznych;

- ściganie przestępstw;

- zarządzanie migracją, azylem i kontrolą granic;

- pomoc w interpretacji prawnej i stosowaniu prawa;

3 | System AI ogólnego przeznaczenia i generatywne

To systemy sztucznej inteligencji tworzące nowe treści – generatywna sztuczna inteligencja. Przykładem jest ChatGPT. Takie narzędzia będą musiały spełnić wymogi dotyczące przejrzystości, takie jak:

- poinformowanie, że treść została wygenerowana przez sztuczną inteligencję;

- zaprojektowanie modelu tak, aby nie generował on nielegalnych treści;

- publikowanie streszczeń chronionych prawem autorskim danych wykorzystywanych do szkoleń;

4 | Ograniczone ryzyko

To systemy AI, które powinny spełniać minimalne wymogi, jeśli chodzi o przejrzystość, umożliwiające użytkownikom podejmowanie świadomych decyzji. Po interakcji z tymi aplikacjami użytkownik będzie mógł następnie zdecydować, czy chce z nich dalej korzystać. Użytkownicy powinni być świadomi, że interakcja odbywa się ze sztuczną inteligencją. Obejmuje to systemy sztucznej inteligencji, które generują obrazy, treści audio lub wideo, lub nimi manipulują, czyli np. wideo typu deepfake.

Parlament chce również ustalenia neutralnej technologicznie, jednolitej definicji sztucznej inteligencji, którą można będzie zastosować do przyszłych systemów AI.

Okiem Eksperta

Paweł Sala

Email Marketing Expert

Jakie są główne wyzwania związane z integracją AI z już istniejącymi systemami marketingowymi?

W mojej ocenie największym wyzwaniem w integracji systemów AI z istniejącymi systemami marketingowymi jest przekonanie, że sztuczna inteligencja wykona za nas – marketerów – całą pracę. Obecnie systemy AI oferują szereg zaawansowanych modeli, które mogą znacząco ułatwić działania marketingowe, pod warunkiem że dostarczymy im odpowiednie dane oraz precyzyjnie sformułujemy pytania. Niestety, wielu marketerów wciąż nie rozumie, jak działają modele AI w 2024 roku i jakie są ich ograniczenia. Dlatego uważam, że kluczowe znaczenie ma edukacja i zrozumienie, czego obecne systemy AI nie potrafią zrobić dobrze. To jest fundament, aby cały ekosystem, który chcemy zbudować w firmie, działał poprawnie i realnie zwiększał efektywność działań marketingowych.

Co więcej, moim zdaniem, dzisiaj potrzeba znacznie większego nakładu pracy na etapie „przygotowania zadań” oraz kontroli wykonanych działań, jeśli chcemy zaangażować mechanizmy AI. Dlatego bardzo ważnym aspektem jest wykorzystanie możliwości AI do automatyzacji powtarzalnych zadań, aby zaoszczędzony czas ludzie mogli przeznaczyć na działania kreatywne, research i zbieranie danych wejściowych, myślenie strategiczne oraz kontrolę tego, co wygenerują mechanizmy AI.

Oceny zgodności – conformity assessments (CA)

Spośród przedstawionych poziomów ryzyka systemy wysokiego ryzyka będą najbardziej problematyczne, jeśli mowa o ich zgodności z dyrektywą, ponieważ przez cały czas będą musiały być podawane monitoringowi w zakresie ocen zgodności. CA wymagają od firm gwarancji, że ich systemy AI wysokiego ryzyka spełniają wymienione kryteria:

- dysponują jakościowymi danymi, wykorzystywanymi do szkolenia, walidacji oraz testowania systemów AI; takowe dane muszą być “reprezentatywne, wolne od błędów oraz kompletne”;

- posiadają szczegółową dokumentację techniczną;

- prowadzą ewidencję w formie automatycznego zapisu zdarzeń;

- dostarczają użytkownikom przejrzystych informacji;

- nadzorują je ludzie;

CA będą obowiązkowe przed wypuszczeniem lub zastosowaniem danego systemu bądź narzędzia AI na rynku europejskim.

Główną stroną odpowiedzialną za CA jest „dostawca” – podmiot wprowadzający system na rynek. Jednakowoż w pewnych okolicznościach odpowiedzialność może zostać przerzucona na producenta, dystrybutora lub importera, zwłaszcza gdy modyfikują oni system lub jego przeznaczenie.

Okiem Eksperta

Bartosz Kastelik

Global Chief Sales Officer w WhitePress

W jaki sposób AI może pomóc w optymalizacji budżetów marketingowych?

Jeżeli przyjmiemy, że budżet marketingowy to suma wydatków przeznaczonych na kampanie marketingowe (w tym koszty obsługi specjalistów), to bezpośredni potencjalny wpływ na te koszty przede wszystkim może mieć automatyzacja procesów opartych na danych, za pomocą narzędzi AI. Dzięki narzędziom wykorzystującym AI już dziś możemy sporą część procesów marketingowo-analitycznych oddać w ręce narzędzi AI, przez co znacznie optymalizujemy czas i koszt, otrzymując jakościowe rezultaty. Kolejną konsekwencją wykorzystania narzędzi sztucznej inteligencji jest reaktywna optymalizacja treści oraz kanałów dystrybucji, która pozwala na poprawę relacji kosztu do otrzymanego rezultatu prowadzonych kampanii marketingowych.

Równocześnie dość sceptycznie podchodzę do przekazania w ręce sztucznej inteligencji części kreatywnej pracy marketingu, w tym pełnej automatyzacji tworzenia kontentu (pomimo oczywistego ograniczenia kosztów jego wytwarzania). Już dzisiaj, obserwując politykę gigantów technologicznych, takich jak Google czy Meta, możemy zaobserwować znacznie ograniczenie zasięgów treści generowanych przez AI. Głównym powodem tego stanu rzeczy jest jakość interakcji użytkownika z treścią, która wypada zdecydowanie słabiej dla treści generowanych bezpośrednio przez narzędzia AI.

Systemy sztucznej inteligencji a prawa autorskie

Zgodnie z polskim prawem, dzieła stworzone przez AI nie są utworami i nie obejmują ich prawa autorskie. Wynika to przede wszystkim z faktu, że utwór podlegający ochronie na podstawie praw autorskich może stworzyć tylko człowiek, co w bezpośredni sposób wyklucza z grona twórców sztuczną inteligencję. Wymóg, aby twórcą utworu był człowiek, powszechnie przyjmuje się w porządkach prawnych zdecydowanej większości państw świata, jednakże postulaty, aby objąć ochroną prawa autorskiego także wytwory sztucznej inteligencji, są coraz częstszym przedmiotem debaty.

Warto podkreślić, że użytkownicy korzystający z narzędzi AI nie mogą rościć sobie do takiego dzieła ani osobistych, ani majątkowych praw autorskich.

Jeśli dany program komputerowy jest oparty na sztucznej inteligencji, to znajduje się on pod ochroną krajowego prawa autorskiego, jednakże ochrona ta nie rozciąga się już na dzieła stworzone w wyniku korzystania z niego przez jego użytkowników. Twórcy sztucznej inteligencji mogą zatem zakazać innym podmiotom skopiowania ich programów i ich udostępniania innym użytkownikom, natomiast nie mają żadnych praw autorskich do rezultatów pracy użytkowników tych programów.

Okiem Eksperta

Weronika Modzelewska

Creative Owner w Przystanek Internet

W jaki sposób AI może wpłynąć na relacje między markami a konsumentami? Czy wykorzystanie sztucznej inteligencji nie zaprzecza transparentności?

Rewolucja AI, która dzieje się na naszych oczach, niewątpliwie będzie wpływała też na relacje między markami a konsumentami. Coraz więcej firm zaczyna wdrażać różnego rodzaju chatboty czy voiceboty w procesie obsługi klienta. Może to poprawiać doświadczenia użytkownika (szybka odpowiedź), ale też prowadzić do frustracji (jeśli bot nie jest w stanie odpowiednio rozwiązać problemu). W marketingu podnosi się na pierwszy plan strategie skupiające się na zaspokajaniu rzeczywistych potrzeb klienta, co wymaga od firm elastyczności i zdolności do szybkiego reagowania na zmiany. W mojej ocenie będzie to tym bardziej zyskiwało na znaczeniu, im bardziej będzie rozwijał się rynek sztucznej inteligencji. Coraz bardziej jako konsumenci będziemy doceniali firmy i rozwiązania oparte na doświadczeniu z drugim człowiekiem, ale też dopasowane personalnie pod nasze potrzeby i wyzwania (jak na przykład rekomendacje na Netflixie). Samo wykorzystanie sztucznej inteligencji w firmach będzie nieuniknione, nie musi to jednak zaprzeczać transparentności, o ile będzie jasno zakomunikowane i przedstawione.

Czy w takim razie możemy założyć, że nowoczesne technologie, takie jak sztuczna inteligencja i zaawansowana analiza danych, pomogą firmom w lepszym rozumieniu i spełnianiu oczekiwań klientów? Czy może je w pewnym sensie „odhumanizują”? Na to pytanie jako marki i konsumenci musimy już wkrótce wypracować odpowiedź.

Z racji tego, że dzieło wygenerowane przez AI nie jest utworem, z punktu widzenia prawa autorskiego można wykorzystywać je w każdym celu, w tym w celach komercyjnych.

Warto mieć na uwadze, że o ile AI nie jest w stanie stworzyć własnego dzieła chronionego prawami autorskimi, tak może już naruszyć prawa autorskie innych twórców, czyli popełnić plagiat.

Z uwagi na nowość tego zagadnienia i brak jego jednoznacznego uregulowania, prawny status przeróbki będącej dziełem AI jest aktualnie interpretowany bardzo różnie. Co więcej, zagadnienie to nie było jeszcze przedmiotem rozstrzygnięcia polskiego sądu. Biorąc pod uwagę fakt, że taka przeróbka nie może zostać uznana za tzw. utwór zależny, najbardziej adekwatne wydaje się przyjęcie, że jest ona szczególną wariacją utworu pierwotnego. Z przeróbki, którą stworzyła AI, można korzystać, ale pod warunkiem posiadania licencji udzielonej przez rzeczywistego twórcę utworu pierwotnego.

Twórcy programów opartych o AI bardzo często przyznają użytkownikom bardzo szerokie uprawnienia w zakresie korzystania ze stworzonych za ich pomocą dzieł, np.:

- regulamin narzędzia ChatGPT przenosi na użytkownika wszelkie prawa do dzieł stworzonych za jego pomocą. Ponadto, na użytkownika przechodzi także wszelka odpowiedzialność za wykorzystanie tego dzieła;

- użytkownik korzystający z wersji odpłatnej narzędzia Midjourney uzyskuje wszelkie prawa do stworzonego dzieła. Jeżeli natomiast korzysta on z wersji nieodpłatnej, może korzystać z dzieła na podstawie licencji CC BY-NC 4.0;

- regulamin OpenAI mówi, że pełnia praw przekazywana jest do domeny publicznej na podstawie licencji CC0 1.0.

Okiem Eksperta

Tomasz Palak

Radca prawny, prelegent, bloger

W jakim zakresie szkolić zespoły z korzystania z AI, aby działania były nie tylko efektywne, ale też zgodne z prawem?

Kluczowe aspekty w relacji prawa i sztucznej inteligencji to własność intelektualna, odpowiedzialność i wszelkiego rodzaju tajemnice. Po pierwsze – zespół powinien być świadomy treści, na jakich wytrenowano dane narzędzie AI i ich legalności. Po drugie – analogicznie – w jaki sposób przedstawia się kwestia praw autorskich czy znaków towarowych przy umieszczaniu ich w narzędziu w celu obróbki. Ostatecznie – co wcale nie najmniej ważne – po prostu tego, kto ma prawa autorskie do treści, którą wygenerowaliśmy… o ile w ogóle ktoś je ma.

Co do odpowiedzialności – twórcy narzędzi oczywiście lubią zrzucać ją z siebie w regulaminach, których nikt z zespołu przed użyciem nie czyta. Świadomość tego – oraz faktu, że użycie AI nieraz nie zwalnia z odpowiedzialności na przykład za halucynacje nas – to kolejna warstwa, o której warto pomyśleć.

Finalną natomiast są wszelkiego rodzaju tajemnice, choćby po prostu firmowe. Czy na pewno ChatGPT ma znać wyniki finansowe danego działu firmy? Tym bardziej, że wskutek błędu czy włamania mogą potem poznać je wszyscy? Albo dane osobowe – zapewne te osoby nie wyrażały zgody na dzielenie się informacjami o nich z taką firmą. Polecam traktować AI jako dość plotkaskiego wspólpracownika, który wszystko chętnie wygada.

Przy uwzględnieniu i najlepiej przeszkoleniu z tych trzech płaszczyzn prawne tematy powinny być w podstawowym zakresie opanowane.

Oznaczanie wytworów AI

Zgodnie z ustawą o usługach cyfrowych (DSA), największe platformy internetowe (tzw. VLOPy), takie jak Meta, Instagram, TikTok czy X, będą musiały specjalnie oznaczać treści wygenerowane przez sztuczną inteligencję i to jeszcze przed oficjalnym ustanowieniem AI Act.

Wiele platform posiada własne regulacje dotyczące treści tworzonej przy użyciu sztucznej inteligencji. Niektóre wyraźnie zezwalają na treści generowane przez AI, podczas gdy inne mogą nałożyć ograniczenia lub nawet ich zakazać (np. na TikToku można publikować filmy generowane lub modyfikowane przez AI, ale deepfake’i osób prywatnych są już niedozwolone).

Jak wygląda kwestia treści pisanych, generowanych przy pomocy AI? Google nie wymaga specjalnego oznaczania takowych materiałów, jednakże umożliwia takie działanie. Firma nie oznacza także treści generowanych przez sztuczną inteligencję inaczej niż materiałów stworzonych przez człowieka. Google nie dba o to, kto stworzył dany artykuł czy inny tekst, zwraca zaś szczególną uwagę na jakość materiału. Oznaczenie – lub jego brak – przy artykule, nie wpłynęłoby – zdaniem firmy – w żaden sposób na doświadczenie czytelnika.

Okiem Eksperta

Łukasz Hardek

Customer Success Manager w ContentHouse

W jaki sposób AI może wspierać proces kwalifikacji leadów w kontekście klientów biznesowych?

AI może znacząco wspierać proces kwalifikacji leadów w kontekście klientów biznesowych (B2B) poprzez automatyzację i ulepszanie różnych etapów tego procesu. Oto kilka sposobów jak można ją wykorzystać:

1. Automatyczne zbieranie i analiza danych

AI może automatycznie zbierać i analizować dane z różnych źródeł, takich jak strony internetowe, media społecznościowe, czy systemy CRM. Analiza tych danych dostarczy informacje o potencjalnych leadach, jak potrzeby, zainteresowania i zachowania zakupowe.

2. Scoring leadów

Algorytmy AI mogą być używane do automatycznego przypisywania punktów leadom na podstawie ich cech i zachowań. Scoring leadów pozwala na szybsze i bardziej precyzyjne określenie, które leady mają największy potencjał do konwersji.

3. Personalizacja komunikacji

Sztuczna Inteligencja może analizować dane dotyczące preferencji i zachowań leadów, aby dostarczać spersonalizowane treści marketingowe i oferty.

4. Predykcyjna analiza leadów

AI może przewidywać, które leady są najbardziej skłonne do konwersji na podstawie analizy danych historycznych. Predykcyjne modele analizy leadów mogą uwzględniać różne czynniki, takie jak demografia, historia interakcji z firmą, czy zachowania na stronie internetowej.

5. Automatyzacja procesów

Narzędzia AI mogą automatyzować wiele rutynowych zadań związanych z kwalifikacją leadów, takich jak wysyłanie e-maili follow-up, umawianie spotkań, czy aktualizacja danych w systemie CRM. Automatyzacja pozwala zespołom sprzedażowym skoncentrować się na bardziej strategicznych działaniach.

6. Chatboty i wirtualni asystenci

Chatboty wykorzystujące AI mogą prowadzić wstępne rozmowy z leadami, zbierać informacje o ich potrzebach i kwalifikować je na podstawie zdefiniowanych kryteriów. Wirtualni asystenci mogą również odpowiadać na pytania klientów w czasie rzeczywistym.

Wdrożenie AI w procesie kwalifikacji leadów może przynieść znaczne korzyści, poprawiając efektywność, precyzję i skuteczność działań sprzedażowych.

Władze unijne z kolei, w myśl walki z dezinformacjami, będą wymagały oznaczania treści stworzonych przez AI – nie oznacza to jednak dodawania do artykułów wielkiego nagłówka o treści “WYGENEROWANE PRZEZ ROBOTA”.

Według władz Wspólnoty, oznaczanie treści generowanych przez AI może być zalecane z punktu widzenia etyki, transparentności i zaufania do technologii – uświadamia to użytkowników, że treść została wygenerowana przez algorytmy, co może wpływać na sposób, w jaki odbierają i interpretują informacje.

Na platformach społecznościowych oznaczanie treści generowanych przez AI ułatwiają narzędzia dostarczane przez dane serwisy. W przypadku zdjęć blogowych można umieścić informację o wykorzystaniu AI w opisie ALT danego obrazu. W przypadku większości treści wystarczy zapis pod artykułem, np. “Treść wygenerowana przez sztuczną inteligencję” czy “Artykuł współtworzony przez sztuczną inteligencję”.

Okiem Eksperta

Dominika Bucholc

AI & Strategy Expert w Bucholc Consulting

Jakie są najważniejsze wyzwania etyczne i moralne związane z zastosowaniem AI w strategii marki?

Podczas kształtowania strategii marki sztuczna inteligencja może wspierać, chociażby proces definiowania i rozwijania tożsamości marki, gdzie AI może sugerować pewne strategie na podstawie analiz rynkowych i trendów. Natomiast należy pamiętać, że to po naszej stronie leży kwestia oceny etyczności tych praktyk, tak aby wartości i priorytety marki były zgodne z rzeczywistymi przekonaniami i kulturą organizacyjną firmy, a nie tylko dopasowane do aktualnych trendów dla krótkoterminowych korzyści. Należy pamiętać, aby wszelkie działania dotyczące pozycjonowania marki na rynku czy kreowania unikalności i przewagi konkurencyjnej przy pomocy AI były prowadzone z poszanowaniem etycznych standardów, takich jak unikanie manipulacyjnych technik i dbanie o autentyczny dialog z odbiorcami.

Najważniejsze, aby sztuczna inteligencja była wykorzystywana w sposób transparentny, uczciwy i zgodny z wartościami firmy, wspierając etyczne budowanie marki bez zastępowania ludzkiej odpowiedzialności i moralnych decyzji w duchu Human+AI Collaboration.

Regulacje dotyczące AI vs marketerzy

Dyrektywa AI Act obowiązuje wyłącznie w Europie. Firmy spoza obszaru regulacji AI Act nie muszą brać pod uwagę tych europejskich wymogów i nie ponoszą związanych z nimi kosztów ani formalności, dopóki ich działalność nie obejmuje krajów Wspólnoty i ich obywateli.

AI Act dotyczy marketerów korzystających ze sztucznej inteligencji w swoich kampaniach skierowanych do publiczności w UE. Obejmuje to zarówno marketerów mających siedzibę na terytorium Unii, jak i tych działających poza jej granicami, ale kierujących swoje działania do konsumentów z UE.

Okiem Eksperta

Michał Grzebyk

PR & Content Marketing Director w CONTENTHOUSE

W jaki sposób AI może wspierać rozwój programów lojalnościowych i budowanie trwałych relacji z odbiorcami?

Sztuczna inteligencja odgrywa obecnie ważną, a może nawet kluczową rolę w rozwoju programów lojalnościowych. Dlaczego? Ponieważ oferuje personalizację nagród i promocji na podstawie analizy danych zakupowych i preferencji klientów. I to wszystko „na sterydach”. Dzięki AI oferty są dostosowywane w czasie rzeczywistym, co wydatnie zwiększa zaangażowanie i satysfakcję odbiorców.

Chatboty wykorzystujące AI ulepszają komunikację. Szybko odpowiadają na zapytania klientów i oferują pomoc na wysokim poziomie. Poprawiają tym samym wrażenie dostępności marki i szybkość reakcji na potrzeby konsumentów.

AI pomaga też w prognozowaniu trendów rynkowych, co umożliwia firmom optymalizację strategii magazynowych i marketingowych, minimalizując koszty i podnosząc efektywność operacyjną.

Systemy AI analizujące opinie w mediach społecznościowych dostarczają wartościowych informacji o satysfakcji klientów. To bezpośrednio przekłada się na potencjał szybkiego reagowanie na ich oczekiwania i poprawę jakości obsługi. Wdrożenie AI w programach lojalnościowych nie tylko zwiększa personalizację i efektywność, ale również umożliwia budowanie trwałych, wartościowych relacji z klientami, kluczowych dla utrzymania przewagi rynkowej.

Najważniejszymi kwestiami, które każdy marketer korzystający z narzędzi AI powinien mieć na uwadze, są:

- regulacja zastosowania AI w marketingu – celem przepisów jest przede wszystkim uregulowanie zastosowań sztucznej inteligencji, które mogą mieć negatywny wpływ na konsumentów. W przypadku marketerów może to obejmować chatboty oparte na sztucznej inteligencji, spersonalizowane systemy rekomendacji treści i reklamy ukierunkowane;

- zakazane praktyki AI – zabronione jest wykorzystywanie sztucznej inteligencji w sposób podstępny lub podświadomy w celu manipulowania zachowaniami klientów. Obejmuje to np. publikowanie fałszywych recenzji lub referencji od fałszywych klientów. Kolejną rzeczą zabronioną jest wykorzystywanie sztucznej inteligencji do atakowania określonych grup demograficznych na podstawie wrażliwych cech, takich jak rasa czy religia;

- systemy wysokiego ryzyka AI – marketerzy korzystający ze sztucznej inteligencji do automatycznego podejmowania decyzji w kampaniach muszą przestrzegać określonych wymagań. Obejmują one przeprowadzenie poważnej oceny ryzyka, dobre udokumentowanie wszystkiego i zapewnienie możliwości zastąpienia lub obejścia decyzji podjętych przez oprogramowanie;

- przejrzystość i kontrola – marketerzy muszą jasno informować klientów, kiedy ci wchodzą w interakcję z systemami opartymi na sztucznej inteligencji. Klient powinien również mieć możliwość rezygnacji lub uzyskania pomocy człowieka, gdy ma do czynienia z treściami opartymi na sztucznej inteligencji;

- prywatność i dane osobowe – wszelkie dane osobowe, wykorzystywane w kampaniach opartych na sztucznej inteligencji, należy traktować zgodnie z przepisami o ochronie danych (RODO);

Okiem Eksperta

Agnieszka Grzesiek-Kasperczyk

Radca prawny w MyLo | POGODA GŁADKI GRZESIEK sp.k.

Jakie są najważniejsze wyzwania związane z ochroną danych osobowych w kontekście używania AI dla celów marketingu?

RODO wprost nie stoi na przeszkodzie samemu używaniu narzędzi AI, jeśli nawet miałyby w takim narzędziu być przetwarzane dane osobowe. Jednak należy zadbać – tak jak przy używaniu każdego innego narzędzia SaaS – o następujące kwestie:

- czy mamy zwartą umowę powierzenia z dostawcą narzędzia?

- czy mamy kontrolę nad tym, by dane wgrywane przez nas do narzędzia, nie były wykorzystywane przez dostawcę do innych celów, niż nasze?

Podstawowym problemem może być to, że wszelkie programy typu „open AI” zastrzegają w swych regulaminach, iż wszystko, co użytkownik „wrzuci” do narzędzia, będzie wykorzystywane również na cele innych użytkowników, tj. przede wszystkim w celu rozwoju algorytmów samego narzędzia. Tymczasem osoby, które nam przekazały swoje dane osobowe (np. baza klientów, baza marketingowa, wizerunki osób, które wyraziły nam zgodę na wykorzystanie ich wizerunku), raczej nie obejmowały swoją zgodą (ani nawet swoją świadomością) tego, że ich dane mogą być wykorzystane na cele:

– uczenia się algorytmu dostarczanego przez zewnętrzną firmę,

– na cele jakichkolwiek podmiotów trzecich, o których ta osoba nawet nie ma pojęcia (chodzi o pozostałych użytkowników narzędzia AI).

Problematyczne może być również korzystanie z narzędzi AI pochodzących z krajów poza UE i USA. Jeśli bowiem dane osobowe mają być przekazane poza UE, to musi istnieć do tego stosowna podstawa, np. pomiędzy UE a USA jest zawarta stosowna umowna. Jednak w odniesieniu np. do Chin – korzystanie z tamtejszych narzędzi AI może być wątpliwe prawnie.

Unijna ustawa o sztucznej inteligencji przewiduje zdecentralizowane egzekwowanie przepisów, uprawniając państwa członkowskie do ustanawiania własnych przepisów dotyczących kar, w tym administracyjnych kar pieniężnych za naruszenia ustawy. Każde państwo członkowskie musi zatem wyznaczyć co najmniej jeden organ krajowy, który będzie nadzorował wdrażanie przepisów i nadzór rynku.

| Wprowadzony przez władze UE czterostopniowe podejście do kar za nieprzestrzeganie postanowień dyrektywy dot. AI | ||||

| Pogwałcona dyrektywa: | Nieprzestrzeganie zakazu stosowania praktyk związanych ze sztuczną inteligencją; | Nieprzestrzeganie wymogów w zakresie zarządzania danymi i przejrzystości odnoszących się do systemów sztucznej inteligencji wysokiego ryzyka; | Nieprzestrzeganie innych wymogów dotyczących systemów sztucznej inteligencji wysokiego ryzyka; | Przekazywanie właściwym organom krajowym fałszywych lub wprowadzających w błąd informacji; |

| Kara maksymalna (w euro): | 40 mln | 20 mln | 10 mln | 5 mln |

Bibliografia

- Notes from the AI frontier: Modeling the impact of AI on the world economy

- Artificial Intelligence (AI) Marketing Benchmark Report: 2023

- EU AI Act: first regulation on artificial intelligence

- AI Act: a step closer to the first rules on Artificial Intelligence

- A European approach to artificial intelligence

- Jak korzystać ze sztucznej inteligencji (AI)? Poradnik od prawnika

- AI Content Labeling: Google’s Policy and How It Affects Your Content

- What marketers should know about the European AI Act

- Navigating the Draft EU AI Act

- EU commission: Tech giants must label AI-generated content

- EU AI Act: implications for VLOPs and Digital Services Act

- 5 głównych trendów regulacyjnych w zakresie sztucznej inteligencji

- Badanie EY: implementacja narzędzi sztucznej inteligencji w polskich firmach nabiera tempa

- Regulacje ws. sztucznej inteligencji: oczekiwania Parlamentu

- Key Issues Fines/Penalties

- Firmy z USA wydają się wyprzedzać UE pod względem wykorzystania big data i AI